Die Daten des Forschungsprojektes sind frei verfügbar 1 2 3 und erlauben es anderen Forschern, an verschiedenen Aspekten des Projektes weiterzuarbeiten – sei es bezüglich Objekterkennung, Handsteuerung mit Elektromyografie, Beschleunigungssensoren oder Einbeziehung des Eyetrackers.

Einleitung

Es gibt verschiedene Steuerungssysteme für Handprothesen:

- Habitusprothesen, die zusätzlich eventuell ein Werkzeug oder einen Haken aufweisen, um einfache Funktionen zu übernehmen;

- mechanische Eigenkraftprothesen, die z. B. mit einer Schulterbewegung gesteuert werden (also nicht „natürlich“); diese können z. B. per Motor gesteuerte Öffnen- oder Schließbewegungen ausführen;

- bei myoelektrischen Prothesen messen Elektroden auf der Haut die Muskelpotenziale im verbliebenen Arm 4.

Myoelektrische Prothesen bieten normalerweise die größte Funktionsvielfalt, auch wenn die Hand komplett fehlt: Alle Fingermuskeln bis auf die des Daumens enden am Ellenbogen, sind also zumindest theoretisch verfügbar und können in der Regel über die entsprechenden Neuronen weiterhin gesteuert werden, auch wenn nach einer Amputation eine Reorganisation im Gehirn stattfindet. Muskelsignale können auf der Haut, direkt am Muskel oder auch im Gehirn entnommen werden 5, wobei nur die Positionierung der Elektroden auf der Haut ein nichtinvasives Verfahren ist. In der Realität liegen die Abbruchraten in der prothetischen Rehabilitation nach Amputation der oberen Extremitäten immer noch nachweislich hoch (auch in aktuellen Studien über 40 %) 6. Als anhaltende Gründe für den Verzicht auf eine Prothese der oberen Extremitäten werden neben einer ungünstigen Stumpfsituation oder einem zu hohen Prothesengewicht insbesondere die Aspekte Bequemlichkeit und Funktion genannt 7.

In mehreren Forschungsprojekten wurden bereits Roboterarme mit fünf einzeln steuerbaren Fingern entwickelt, deren Konstruktionsdetails teils kostenlos aus dem Internet heruntergeladen und die dann mittels 3D-Druck erstellt werden können 8. Sie verursachen niedrigere Kosten als professionelle Prothesen, weisen allerdings häufig nicht die gleiche Robustheit auf und haben auch andere Mängel, etwa eine langsame Griffgeschwindigkeit, eine limitierte Griffkraft oder eine begrenzte proportionale Kontrolle. Diese Prothesen erlauben aber eine große Anzahl an Bewegungen mit einer „natürlichen“ Steuerung.

Zusätzlich zu elektrischen Muskelpotenzialen können noch weitere Signale zur Steuerung von Handprothesen verwendet werden:

- klinische Parameter 9,

- Beschleunigungssensoren 10,

- eine Kamera in der Prothese 11 oder

- eine „intelligente Brille“ mit Kamera 12.

Sowohl das sogenannte Maschinelle Lernen als auch „Deep Learning“ 13 erlauben es, zumindest in der Forschung sehr gute Resultate zu erzielen, wozu aber in der Regel eine exakte Kalibrierung bei jeder Benutzung notwendig ist, da eine exakte Positionierung und externe Faktoren die Qualität der Bewegungserkennung beeinflussen. Eine solche regelmäßige Kalibrierung führt in der Praxis aber zu Schwierigkeiten, deshalb wird auch zukünftig mehr Forschung benötigt, um Kalibrierungen zu limitieren und stabile Resultate zu erzielen.

Methoden

Im Folgenden wird das Setup beschrieben, das innerhalb des Forschungsprojekts „MeganePro“, finanziert vom Schweizer Nationalfonds, erstellt wurde.

Innerhalb des Projekts wurden verschiedene Techniken erprobt sowie unterschiedliche Handbewegungen und diverse Objekte in den Experimenten verwendet. Vorrangiges Ziel des Projektes ist es, realistische tägliche Aktivitäten von Menschen mit Handamputation zu vereinfachen, um die Entwicklung von Handprothesen zu verbessern.

Geräte zur Datenerfassung

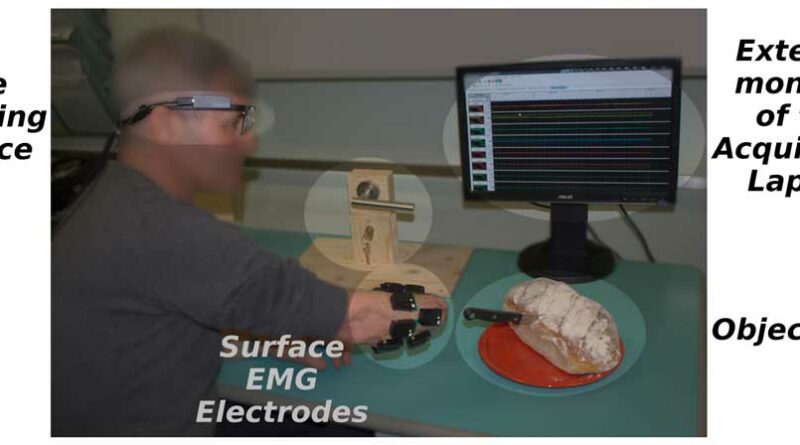

Im Projekt wurden verschiedene sEMG-Elektroden verwendet und getestet 14. Für die Haupttests mit einer großen Zahl von Personen mit Amputation und dem Eyetracker 15 wurden „Trigno“-Elektroden des Herstellers Delsys benutzt, die auch Beschleunigungssensoren beinhalten 16 17 und das Signal kabellos übertragen. Abbildung 1 zeigt das Setup mit den Elektroden, die auf den Arm geklebt werden, verschiedene Objekte, die von den Probanden gegriffen werden sollen, sowie einen Bildschirm, der die Signale visualisiert.

Für die Blickverfolgung wird ein Eyetracker „Tobii Pro“ (Tobii AB, Schweden) mit Kamera für das Sichtfeld der Probandinnen und Probanden mit Amputation benutzt (Abbildung 2). Die Auswahl dieses Eyetrackers für die Zwecke des Projekts beruht auf einer detaillierten Analyse in 18, in der unterschiedliche Geräte miteinander verglichen werden.

Alle Daten werden auf einem Laptop erfasst und müssen dann synchronisiert werden, da die Frequenzen der gemessenen Werte sehr unterschiedlich sind (sEMG, Beschleunigungssensoren, Kamera, Blickverfolgung). Die Aufgaben, die die Probanden mit Amputation zu absolvieren haben, werden akustisch per Software in der vorab gewählten Sprache erläutert (auf Italienisch, Deutsch, Französisch oder Englisch), damit die Testpersonen nicht mit den Augen den Vorgaben auf einem Bildschirm folgen müssen.

Protokoll zur Datenregistrierung

Das detaillierte Protokoll für die Datenerfassung wird in 19 beschrieben. Es werden Objekte vor der Testperson platziert, die in der Regel mit jeweils unterschiedlichen Griffarten gegriffen werden (Beispiele: Tasse, Messer, Stift; eine Tasse kann mittig zum Trinken oder von oben gegriffen werden, wenn man sie woanders hinstellt). Die Aktionen werden in der gewählten Sprache vorgegeben. Dabei können gleiche Objekte auf verschiedene Arten gegriffen werden (dies wird jeweils in den Instruktionen mitgeteilt), und die gleichen Griffarten können bei verschiedenen Objekten benutzt werden. Eine genaue Beschreibung des Protokolls befindet sich in 20.

Zwischen zwei Griffen wird stets eine Ruhepause eingelegt, was auch erlaubt, die verschiedenen Griffarten zu trennen. Probanden ohne Amputation greifen die Objekte tatsächlich; Testpersonen mit Amputation versuchen, die Bewegungen gedanklich und physisch so natürlich wie möglich auszuführen, ohne dass das Objekt dabei tatsächlich gegriffen wird – es wird dabei keine Prothese benutzt, aber der Arm wird in die Richtung des Objektes bewegt. Dadurch wird ein Einfluss der physischen Prothese auf die Signale limitiert (zum Beispiel durch eine Verzögerung der Bewegung, das Gewicht der Prothese und die Qualität der Bewegungserkennung). Auf der anderen Seite wird die Bewegung nicht beendet, da das Objekt nicht wirklich gegriffen und gehalten wird.

Alle Daten werden aufgezeichnet, sodass die Bearbeitung später auch offline möglich ist. Mehr über die unterschiedlichen Griffarten ist dem Beitrag in 21 zu entnehmen.

In der wissenschaftlichen Literatur sind die Resultate der Erkennung präziser Griffe von Personen mit Amputation, die in den jeweiligen Publikationen beschrieben werden, nur schwer vergleichbar, denn in jedem Experiment werden andere Griffe und Objekte sowie eine unterschiedliche Anzahl an Griffen benutzt. Bei einigen Experimenten wird eine Präzision von 90 % erreicht – jedoch mit nur wenigen Grifftypen. Bei komplexen Experimenten dagegen werden häufig niedrigere Präzisionsraten erzielt. Um die am besten geeigneten Techniken und Ansätze zu ermitteln, ist ein Vergleich, der auf einem einheitlichen Datensatz basiert, daher wichtig. Aus diesem Grund wird die im beschriebenen Projekt erarbeitete Datenbank mit Griffen frei zur Verfügung gestellt. In den zugrunde liegenden Experimenten wurden bewusst sehr komplexe Muster (z. B. „sitzend“ vs. „stehend“) und relativ viele Griffe und Objekte verwendet, um das Potenzial der Forschung zum Maschinellen Lernen aufzuzeigen. Dies sollte im nächsten Schritt auch zu komplexeren kommerziellen Prothesen führen.

Resultate

Hauptresultat des Projektes ist die Datenbank 22, die alle in den Experimenten gewonnenen Daten von 15 Personen mit Amputation und 30 Kontrollpatienten ohne Amputation für die Forschung verfügbar macht. Die Datensätze enthalten die jeweiligen sEMG-Signale, die Beschleunigungssensoren, Videos des Blickfeldes sowie die dynamische Blickverfolgung der Probanden – sowohl grafisch in Form eines Kreises innerhalb der Bilder als auch digital mit den Koordinaten der Blickverfolgung.

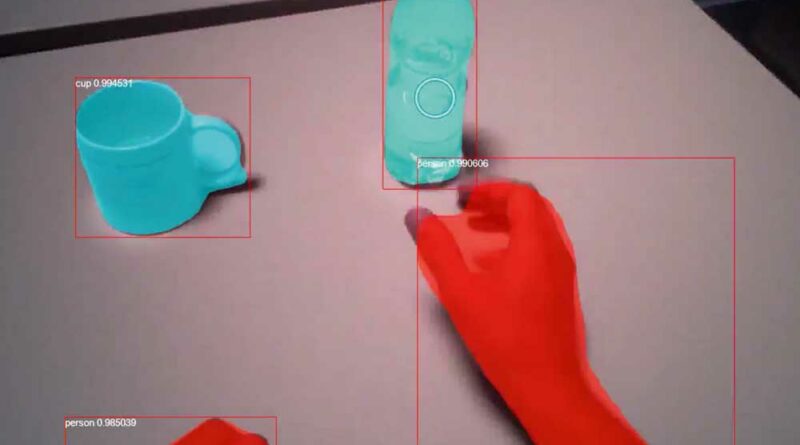

Abbildung 3 zeigt einen Screenshot aus einem der Videos mit dem Blickfeld eines Probanden, das nachträglich mit einer automatischen Objekterkennung bearbeitet wurde, um die Analyse zu vereinfachen. So können erkannte Objekte wie in der Abbildung zu erkennen mit einem Rechteck markiert und im Video mit dem Typ des Objektes getrackt werden (in Abbildung 3 Flasche, Tasse, Hand). Es werden dabei alle Objekte erkannt, also auch die Hand, denn diese ist ebenfalls ein Objekt, das aber in diesem Fall nicht gegriffen werden kann, obwohl die Testpersonen es manchmal fixieren. Der kleine Kreis zeigt den Fixationspunkt an, also wohin die Testperson ihren Blick richtet. Dieser Fixationspunkt bewegt sich ständig, umfasst aber regelmäßig längere (etwa 400 ms) Fokussierungen auf bestimmte Objekte, z. B. kurz bevor diese gegriffen werden.

In einer ersten Studie wurde das Blickmuster von Testpersonen mit und ohne Amputation analysiert, wobei sich interessante kleine Veränderungen ergaben 23: So sind zwar die Augenbewegungsmuster zwischen Probanden mit und ohne Amputation ähnlich, Testpersonen mit Amputation weisen aber eine etwas längere Spanne zwischen Fixierung und Griff auf (1000 ms anstelle von 550 ms).

Eine weitere Datenanalyse ist derzeit (Stand: Dezember 2020) in Arbeit 24, bei der für jede Bewegung automatisch erfasst wird, welches Objekt die jeweilige Testperson etwa 500 ms vor der Greifbewegung fixiert hat. Da für jedes Objekt nur eine limitierte Anzahl von Griffen besteht (zum Beispiel kann eine Tasse entweder von oben oder mittig gegriffen werden), kann die Auswahl der idealerweise von der Prothese auszuführenden Bewegung eingeengt werden. Das führt zu einer deutlichen Qualitätssteigerung der Bewegungserkennung, obwohl noch nicht alle Objekte und Fixierungen korrekt erkannt werden (die Objekterkennung ist für etwa 90 % der zu greifenden Objekte korrekt). Allerdings hat sich innerhalb des Projekts die korrekte Erkennung komplexer Griffe bei Menschen mit Amputation von etwa 63 auf 79 %, bei Probanden ohne Amputation von 73 auf 80 % erhöht. Diese Resultate der Benutzung der Blickfeldkamera für die Steuerung sind dem Beitrag 25 zu entnehmen.

Test anhand einer Prothese

Um aufzuzeigen, dass die erstellten Algorithmen mit einer physischen Prothese tatsächlich in Echtzeit funktionieren, hat das Projektteam eine solche per 3D-Druck erstellt und diese mit vier Probanden mit Amputation und einer limitierten Anzahl von Objekten getestet 26. Die Fixierung am Arm erfolgte dabei der Einfachheit halber mit einem aufgetrennten Kunststoffrohr; ein Myo-Armband wurde als Elektrode benutzt. Es wurden dabei aber nur vier Bewegungen der Finger benutzt, um den Test zu vereinfachen. Die getesteten Bewegungen und Objekte können Abbildung 4 entnommen werden. Mit nur etwa 10 Minuten Training konnten die Probanden mit Handamputation die Prothese sehr gut benutzen und alle gestellten Aufgaben erledigen, wobei dies allerdings teilweise erst im zweiten oder dritten Versuch gelang.

Bei diesem Test wurde die Druckstärke auf die Objekte nicht variiert – insofern erfolgte das Feedback für die Testpersonen dabei nur visuell. Aber allein das hilft schon, da die Probanden ihre „gedachten“ Bewegungen dadurch etwas variieren können. Es wird also keine proportionale Signalkontrolle durchgeführt, auch wenn das mit den Signalen der Elektroden und den in die Hand eingebauten Drucksensoren durchaus möglich wäre.

Diskussion

Die aufwendige Datenerfassung mit einem komplexen Protokoll und 45 Probanden hat insgesamt drei Jahre in Anspruch genommen, aber die Verfügbarkeit der Daten 27 28 wird sicherlich zu weiteren Ergebnissen in der Datenanalyse führen. Die Einbeziehung von Videotechnik mit Objekterkennung und Blickverfolgung bei der Steuerung einer Prothese könnte, wie in den Experimenten ohne Prothesenbenutzung gezeigt wurde, zu deutlich besseren Resultaten bei der Erkennung von Griffen und damit der Steuerung von Prothesen führen und auch deren Robustheit erhöhen, obwohl noch nicht alle Objekte korrekt erkannt werden. Hier besteht noch Potenzial für deutlich bessere Resultate, wenn Forscher aus den Bereichen Objekterkennung, Maschinelles Lernen und Prothesensteuerung zusammenarbeiten.

Fazit und Ausblick

Dieser Artikel beschreibt ein Forschungsprojekt, bei dem Blickverfolgung und Objekterkennung eingesetzt werden, um in Zukunft die Kontrolle von Handprothesen zu verbessern. Die Daten des Projektes werden frei zur Verfügung gestellt 29, und die Verfasser hoffen, damit weitere Forschung zu stimulieren, denn eine so massive Datenerfassung (hier mit 15 Menschen mit und 30 Menschen ohne Amputation) geht mit einem hohen Aufwand einher. Wenn Forschungsgruppen dieser Schritt abgenommen wird, ist davon auszugehen, dass die Forschung im Bereich Handprothetik dadurch sehr erleichtert wird. Da das Forschungsfeld multidisziplinär ist, können sich Forscher entweder auf ihren Bereich konzentrieren (z. B. Objekterkennung oder Maschinelles Lernen unterschiedlicher Signale) oder in anderen Bereichen mit einer weiteren Forschungsgruppe zusammenarbeiten, um funktionelle Handprothesen zu erstellen.

Der Autor:

Prof. Dr. Henning Müller

HES-SO Valais

Techno-Pôle 3, CH-3960 Sierre

Schweiz

henning.mueller@hevs.ch

Begutachteter Beitrag/reviewed paper

Müller H, Atzori M. Handprothesensteuerung durch Blickverfolgung und Objekterkennung. Orthopädie Technik, 2021; 72 (5): 50–55

- Easypreg – ein Faserverbundwerkstoff zum Tiefziehen — 9. März 2026

- Konservative Versorgung einer adulten Skoliose mit einem modularen Bausatz – ein Versorgungsbeispiel — 6. März 2026

- Technologie und Funktionsweise des Prothesenkniegelenks Genium X4 — 13. Februar 2026

- Atzori M, Gijsberts A, Castellini C, Caputo B, Hager AGM, Elsig S, Müller H, et al. Electromyography data for non-invasive naturally-controlled robotic hand prostheses. Scientific Data, 2014; 1 (1): 1–13;

- Atzori M, Gijsberts A, Heynen S, Hager AGM, Deriaz O, van der Smagt P, Müller H, et al. Building the Ninapro database: A resource for the biorobotics community. 4th IEEE RAS EMBS International Conference on Biomedical Robotics and Biomechatronics (BioRob), Rome, June, 2012: 1258–1265;

- Atzori M, Gijsberts A, Kuzborskij I, Elsig S, Hager AGM, Deriaz O, Caputo B, et al. Characterization of a benchmark database for myoelectric movement classification. IEEE Transactions on Neural Systems and Rehabilitation Engineering, 2014; 23 (1): 73–83

- Atzori M, Müller H. Control capabilities of myoelectric robotic prostheses by hand amputees: a scientific research and market overview. Frontiers in Systems Neuroscience, 2015; 9: 162

- Micera S, Carpaneto J, Raspopovic S. Control of hand prostheses using peripheral information. IEEE Reviews in Biomedical Engineering, 2010; 3: 48–68

- Salminger S, Stino H, Pichler LH, Gstoettner C, Sturma A, Mayer JA, Szivak M, Aszmann OC. Current rates of prosthetic usage in upper-limb amputees – have innovations had an impact on device acceptance? Disabil Rehabil, 2020; 30: 1–12. doi: 10.1080/09638288.2020.1866684. PMID: 33377803 [Epub ahead of print]

- Smail LC, Neal C, Wilkins C, Packham TL. Comfort and function remain key factors in upper limb prosthetic abandonment: findings of a scoping review. Disabil Rehabil Assist Technol, 2020; 19: 1–10. doi: 10.1080/ 17483107.2020.1738567. PMID: 32189537 [Epub ahead of print]

- Cognolato M, Atzori M, Marchesin C, Marangon S, Faccio D, Tiengo C, Bassetto F, Gassert R, Petrone N, Müller H. Multifunction control and evaluation of a 3D printed hand prosthesis with the Myo armband by hand amputees. bioRxiv, 2018 [preprint]. doi: 10.1101/445460

- Atzori M, Gijsberts A, Castellini C, Caputo B, Mittaz Hager AG, Elsig S, Müller H, et al. Effect of clinical parameters on the control of myoelectric robotic prosthetic hands. Journal of Rehabilitation Research & Development, 2016; 53 (3): 345–358

- Blana D, Kyriacou T, Lambrecht JM, Chadwick EK. Feasibility of using combined EMG and kinematic signals for prosthesis control: A simulation study using a virtual reality environment. Journal of Electromyography and Kinesiology, 2016; 29: 21–27

- DeGol J, Akhtar A, Manja B, Bretl T. Automatic grasp selection using a camera in a hand prosthesis. 38th Annual International Conference of the IEEE Engineering in Medicine and Biology Society (EMBC), Chicago, August, 2016: 431–434

- Giordaniello F, Cognolato M, Graziani M, Gijsberts A, Gregori V, Saetta G, Caputo B. Megane pro: myoelectricity, visual and gaze tracking data acquisitions to improve hand prosthetics. International Conference on Rehabilitation Robotics (ICORR), London, July, 2017: 1148–1153

- Atzori M, Cognolato M, Müller H. Deep learning with convolutional neural networks applied to electromyography data: A resource for the classification of movements for prosthetic hands. Frontiers in Neurorobotics, 2016; 10: 9

- Atzori M, Müller H. Control capabilities of myoelectric robotic prostheses by hand amputees: a scientific research and market overview. Frontiers in Systems Neuroscience, 2015; 9: 162

- Atzori M, Gijsberts A, Kuzborskij I, Elsig S, Hager AGM, Deriaz O, Caputo B, et al. Characterization of a benchmark database for myoelectric movement classification. IEEE Transactions on Neural Systems and Rehabilitation Engineering, 2014; 23 (1): 73–83

- Atzori M, Gijsberts A, Castellini C, Caputo B, Hager AGM, Elsig S, Müller H, et al. Electromyography data for non-invasive naturally-controlled robotic hand prostheses. Scientific Data, 2014; 1 (1): 1–13

- Cognolato M, Gijsberts A, Gregori V, Saetta G, Giacomino K, Hager AGM, Gigli A, Faccio D, Tiengo C, Bassetto F, Caputo B. 2020. Gaze, visual, myoelectric, and inertial data of grasps for intelligent prosthetics. Scientific Data, 2020; 7 (1):1–15

- Cognolato M, Atzori M, Müller H. Head-mounted eye gaze tracking devices: An overview of modern devices and recent advances. Journal of Rehabilitation and Assistive Technologies Engineering, 2018; 5: 2055668318773991

- Cognolato M, Gijsberts A, Gregori V, Saetta G, Giacomino K, Hager AGM, Gigli A, Faccio D, Tiengo C, Bassetto F, Caputo B. 2020. Gaze, visual, myoelectric, and inertial data of grasps for intelligent prosthetics. ScientificData, 2020; 7 (1):1–15

- Cognolato M, Gijsberts A, Gregori V, Saetta G, Giacomino K, Hager AGM, Gigli A, Faccio D, Tiengo C, Bassetto F, Caputo B. 2020. Gaze, visual, myoelectric, and inertial data of grasps for intelligent prosthetics. ScientificData, 2020; 7 (1):1–15

- Pizzolato S, Tagliapietra L, Cognolato M, Reggiani M, Müller H, Atzori M. Comparison of six electromyography acquisition setups on hand movement classification tasks. PloS One, 2017; 12 (10): e0186132

- Cognolato M, Gijsberts A, Gregori V, Saetta G, Giacomino K, Hager AGM, Gigli A, Faccio D, Tiengo C, Bassetto F, Caputo B. 2020. Gaze, visual, myoelectric, and inertial data of grasps for intelligent prosthetics. Scientific Data, 2020; 7 (1):1–15

- Gregori V, Cognolato M, Saetta G, Atzori M, Caputo B, Gijsberts A. On the Visuomotor Behavior of Amputees and Able-Bodied People During Grasping. Frontiers in Bioengineering and Biotechnology, 2019; 7: 316

- Cognolato M, Atzori M, the MeganePro Consortium, Gassert R, Müller H. Modality Integration based on Eye-hand Coordination to Improve Hand Prosthesis Control. Frontiers, 2021 [under review]

- Saetta G, Cognolato M, Atzori M, Faccio D, Giacomino K, Hager AGM, Brugger P, et al. Gaze, behavioral, and clinical data for phantom limbs after hand amputation from 15 amputees and 29 controls. Scientific Data, 2020; 7 (1): 1–14

- Smail LC, Neal C, Wilkins C, Packham TL. Comfort and function remain key factors in upper limb prosthetic abandonment: findings of a scoping review. Disabil Rehabil Assist Technol, 2020; 19: 1–10. doi: 10.1080/17483107.2020.1738567. PMID: 32189537 [Epub ahead of print]

- Cognolato M, Gijsberts A, Gregori V, Saetta G, Giacomino K, Hager AGM, Gigli A, Faccio D, Tiengo C, Bassetto F, Caputo B. 2020. Gaze, visual, myoelectric, and inertial data of grasps for intelligent prosthetics. Scientific Data, 2020; 7 (1):1–15

- Cognolato M, Graziani M, Giordaniello F, Saetta G, Bassetto F, Brugger P, Atzori M, et al. Semi-automatic training of an object recognition system in scene camera data using gaze tracking and accelerometers. In: Liu M, Chen H, Vincze M (eds). Computer Vision Systems (ICVS, Shenzhen, 2017). Cham: Springer, 2017: 175–184

- Cognolato M, Gijsberts A, Gregori V, Saetta G, Giacomino K, Hager AGM, Gigli A, Faccio D, Tiengo C, Bassetto F, Caputo B. 2020. Gaze, visual, myoelectric, and inertial data of grasps for intelligent prosthetics. Scientific Data, 2020; 7 (1):1–15