Einleitung

Seit Menschengedenken arbeitet man an Arm- und Beinprothesen 1. Der von Plinius dem Älteren beschriebene aus Eisen gefertigte Ersatz der rechten Hand des römischen Offiziers und Politikers Marcus Sergius Silus, der Ende des 3. Jahrhunderts v. Chr. gelebt hat, ist vermutlich die älteste Überlieferung einer Handprothese 2. Ob sie wirklich existierte, lässt sich nur mutmaßen. Die beiden „Eisernen Hände“ des Reichsritters Götz von Berlichingen (1480–1562) hingegen sind erhalten und im Schlossmuseum Jagsthausen zu besichtigen. Sie sind die wohl berühmtesten historischen künstlichen Hände überhaupt und auch heute noch wegen ihrer ausgeklügelten Mechanik, ihrer einfachen Bedienbarkeit und ihrer guten Alltagstauglichkeit eindrucksvoll 3 4 5. Die Steuerung der Finger erfolgte bei den Götz-Händen noch passiv, d. h. mit Hilfe der gesunden Hand. Heute sind die Prothesen motorisiert und werden bislang durch elektrodenbasierte Systeme gesteuert, die Signale vom Gehirn oder den Muskeln verwenden 6. Diese Systeme haben ihre Funktionsfähigkeit zwar erfolgreich unter Beweis gestellt, sind aber sehr teuer, zeitintensiv in der Einrichtung (Kalibrierung) sowie störanfällig. Außerdem fällt es den Betroffenen oft schwer, den Umgang mit ihnen zu erlernen, was die Akzeptanz für solche Systeme bei den Patienten einschränkt 7 8. Ziel der Forscher der Hochschule Offenburg ist es daher, ein robusteres System zur Ansteuerung von Handprothesen zu entwickeln, das alltagstauglich ist und den Bedürfnissen der Patienten gerecht zu werden versucht. Dafür wurde ein neues Verfahren zur Ansteuerung motorisierter Handprothesen entwickelt, das auf Augmented Reality (erweiterter Realität) basiert 9 und auf jegliche myoelektrische Steuerung verzichtet. Dieses Verfahren wurde in der Zeitschrift Scientific Reports veröffentlicht 10 und soll hier – auf Anfrage der Zeitschrift ORTHOPÄDIE TECHNIK – der interessierten Leserschaft in einer detaillierten Zusammenfassung vorgestellt werden.

Vorstellung des Systems

In diesem neu entwickelten Verfahren kann die visuell wahrgenommene Umgebung durch eingeblendete Objekte, wie beispielsweise Steuerflächen, erweitert werden (Abb. 1). Diese eingeblendeten Objekte werden über eine Augmented-Reality-Brille immer ortsfest, d. h. beispielsweise neben der Prothese, angezeigt. Dass die Einblendung der Objekte immer in unmittelbarer Nähe zur Prothese erfolgt, wird durch eine in die Augmented-Reality-Brille integrierte Kamera und einen entsprechenden Algorithmus realisiert: Die Prothese wird mit sieben Infrarot-LEDs (Prothesenmarker) ausgestattet, die in LED-Tripletts angeordnet sind. Sofern die LEDs im Kamerabild sichtbar sind, kann der Algorithmus mittels „pose estimation“ 11 die Position (Translation) und die Orientierung (Rotation) der Prothese ermitteln. Diese Daten (Transformationen) können verwendet werden, um die Prothese im 3D-Raum zu verfolgen und die virtuellen Elemente mittels der Brille kontinuierlich an der richtigen Stelle einzublenden.

Orientierung und Position der Prothese können umgekehrt dazu verwendet werden, Bewegungen des Kopfes des Benutzers zu bestimmen, was einer Bewegung der Kamera in Bezug auf den Prothesenmarker entspricht. Somit kann eine feste virtuelle Linie senkrecht zur Brille, welche die Blickrichtung des Benutzers darstellt, dem Nutzer als Cursor dienen, der sich durch Bewegungen des Kopfes verfahren lässt. Der Benutzer erhält durch den Cursor somit die Möglichkeit, Befehle auf das virtuelle Kommandofeld zu „zeichnen“, welche die Effektoren der Prothese steuern. Das System nutzt die natürliche Blickrichtung der Betroffenen, um mit diesen virtuellen Steuerflächen zu interagieren. Denn ein Mensch, der etwas greifen will, schaut in der Regel ohnehin in die Richtung des zu greifenden Gegenstands und seiner Hand. Orthesen- oder Prothesenträger müssen daher weder etwas wesentlich Neues erlernen noch sich besonders konzentrieren.

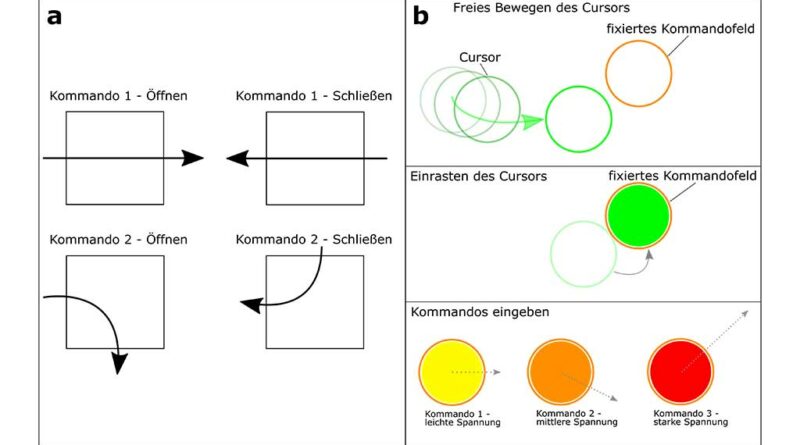

In Abbildung 2 sind beispielhaft zwei verschiedene Möglichkeiten für visuelle Steuerungsmechanismen dargestellt: Beiden Mechanismen ist gemein, dass der Nutzer einen virtuellen Cursor mit seiner Blickrichtung – der Ausrichtung des Kopfes – bewegt. Beim System mit rechteckiger Steuerfläche (Abb. 2a) wird der Cursor über die ortsfest zur Prothese eingeblendete Fläche geführt. Dabei wird ausgewertet, über welche der vier Kanten die Steuerfläche betreten und über welche Kante sie wieder verlassen wird. Eintritts- sowie Austrittskante bestimmen das zugehörige Kommando. Beispielsweise löst eine leichte Kopfbewegung von links nach rechts durch das Kommandofeld das Schließen der Hand, eine leichte Kopfbewegung in die entgegengesetzte Richtung das Öffnen der Hand aus.

In einem anderen System mit runder Steuerfläche (Abb. 2b) muss der Nutzer den Kommandomodus zunächst aktivieren, indem er den Cursor auf das runde Kommandofeld führt, das ebenfalls ortsfest über der Prothese schwebt. Dort rastet der Cursor ein. Ab diesem Moment werden die weiteren Kopfbewegungen des Nutzers als Kommando interpretiert. Durch aktives Bewegen des Cursors gegen diesen scheinbaren Widerstand entsteht eine „virtuelle Spannung“. Deren Stärke und Richtung werden verwendet, um die Prothese entsprechend weit zu schließen bzw. zu öffnen. So wird die Prothese beispielsweise durch eine Bewegung des Kopfes nach rechts geschlossen, während eine Bewegung nach links sie wieder öffnet. Durch eine leichte ruckartige Bewegung, die vom Beschleunigungssensor der Brille erfasst wird, verlässt der Nutzer den Kommandomodus wieder.

Für alle vorgestellten Steuerungen gilt, dass die virtuellen Elemente relativ klein in Bezug zur Umgebung sind und somit nur dann sichtbar werden bzw. im Blickfeld erscheinen, wenn der Patient explizit in Richtung der Prothese blickt. Dadurch wird einerseits das Risiko für unbeabsichtigte Aktivierungen der Prothese minimiert und andererseits der Nutzer nicht durch andauernde Einblendungen im Blickfeld belästigt.

In den meisten Fällen ist es sicherlich am sinnvollsten, die virtuellen Steuerelemente in der Nähe der Prothese einzublenden. Es spricht aus technischer Sicht jedoch nichts dagegen, diese Elemente vom Nutzer – je nach Alltagssituation – an eine andere Stelle seiner Umgebung verschieben zu lassen, beispielsweise, um bei Bildschirmarbeit nicht jedes Mal auf die Prothese schauen zu müssen.

Versuche

Die bisherigen Versuche wurden an einem Styroporkopf (Abb. 1) durchgeführt, der manuell über eine Stange bewegt wurde – eine klinische Studie mit standardisierten Tests an Patienten fand bislang noch nicht statt. Es wurden zwei verschiedene Endeffektoren getestet (Abb. 3):

- Ein 3D-gedrucktes Greifsystem (Abb. 3a) ermöglicht gesunden Probanden, die visuelle Steuerung zu testen. Das Greifsystem wird vom Nutzer wie ein Handschuh getragen. Es enthält zwei verschiedene LED-Konfigurationen (Oberseite und linke Seite). Dadurch wird ermöglicht, die Prothese auch bei starker Drehung der Hand weiterhin zu tracken. Für dieses Greifsystem wurde das oben aufgeführte rechteckige Steuerungssystem verwendet (vgl. Abb. 2a), da es bis zu 16 verschiedene Griffkombinationen ermöglicht, die von dem Greifsystem realisiert werden können.

- Der zweite Endeffektor ist eine kommerziell erhältliche motorisierte Handorthese, und zwar das Modell „NeoMano“ der Firma Neofect (San Francisco, Kalifornien, USA; Abb. 3b), bei der nur der Zeige- und Mittelfinger durch einen Motor gleichzeitig betätigt werden und der Daumen starr bleibt. Für dieses Greifsystem wurde das System mit runder Steuerfläche verwendet (vgl. Abb. 2b), da hier das präzise Schließen bzw. Öffnen der Prothese im Fokus steht. In einem Video wird das System in Betrieb gezeigt 12.

Ergebnisse

In den Tests konnte gezeigt werden, dass ortsfeste Einblendungen in Bezug zur Prothese bzw. Orthese möglich sind. Dies gilt auch, wenn die Prothese bewegt wird – die Einblendung verbleibt in derselben relativen Position zur Prothese und bewegt sich dementsprechend mit. Des Weiteren konnte gezeigt werden, dass nur minimale Kopfbewegungen notwendig sind, um Befehle mit ausreichender Genauigkeit auf den Kommandoelementen zu zeichnen 13.

Fazit

Zwar muss das hier vorgestellte visuelle Verfahren noch in einer klinischen Studie getestet werden, aber die niedrigen Kosten, die Einfachheit der Bedienung und der Verzicht auf störanfällige Elektroden machen das System zu einer vielversprechenden Lösung zur Wiederherstellung der Handfunktion. Durch den Einsatz künstlicher Intelligenz soll die Verarbeitung der Befehle überdies robuster und für den Patienten personalisierbar werden. An beiden Aspekten – der klinischen Studie mit standardisierten Tests zur Evaluation des Systems sowie dem Einsatz künstlicher Intelligenz – wird derzeit an der Hochschule Offenburg gearbeitet.

Für die Autoren:

Prof. Dr. med. Andreas Otte

Peter-Osypka-Institut für Medizintechnik

Fakultät Elektrotechnik, Medizintechnik

und Informatik

Hochschule Offenburg

Badstr. 24, D‑77652 Offenburg

andreas.otte@hs-offenburg.de

Begutachteter Beitrag/reviewed paper

Hazubski S, Hoppe H, Otte A. Neues Konzept für die Aktivierung künstlicher Hände durch Augmented Reality. Orthopädie Technik, 2021; 72 (7): 40–42

- Dynamische Unterschenkelorthese in Prepreg-Technik nach Hafkemeyer – Konstruktionsmerkmale, Indikationen, Variationsmöglichkeiten — 3. April 2024

- Bringt die Stand- und Schwungphasenkontrolle einen Vorteil bei KAFO-Trägern? Ergebnisse einer internationalen randomisiert-kontrollierten Studie — 3. April 2024

- Dynamische CDS-Knieredressionsorthesen bei Kindern und Jugendlichen mit Cerebralparese GMFCS-Level II–III — 3. April 2024

- Ohnemus D, Otte A. Medico-historical findings of (neuro-) prosthetics: an online survey. Arch Kriminol, 2014; 234 (5–6): 201–208

- Weinert O, Otte A. Die eiserne Hand des römischen Offiziers Marcus Sergius Silus (Ende des 3. Jahrhunderts v. Chr.) – eine 3‑D Computer-Aided Design (CAD)-Simulation. Arch Kriminol, 2018; 242(5–6): 184–192

- Quasigroch G. Die Handprothesen des fränkischen Reichsritters Götz von Berlichingen. 1. Fortsetzung: Die Ersthand. Z der Ges für hist Waffen- und Kostümkunde, 1982; 24: 17–33

- Quasigroch G. Die Handprothesen des fränkischen Reichsritters Götz von Berlichingen. 2. Fortsetzung: Die Zweithand. Z der Ges für hist Waffen- und Kostümkunde, 1983; 25: 103–120

- Otte A. 3D Computer-Aided Design Reconstructions and 3D Multi-Material Polymer Replica Printings of the First “Iron Hand” of Franconian Knight Gottfried (Götz) von Berlichingen (1480–1562): An Overview. Prosthesis, 2020; 2: 304–312

- McMullen DP et al. Demonstration of a semi-autonomous hybrid brain-machine interface using human intracranial EEG, eye tracking, and computer vision to control a robotic upper limb prosthetic. IEEE transactions on neural systems and rehabilitation engineering: a publication of the IEEE Engineering in Medicine and Biology Society, 2014; 22: 784–796

- Otte A. Smart Neuroprosthetics Becoming Smarter, but Not for Everyone? EClinical Medicine, 2018; 2–3: 11–12

- Soekadar SR et al. Hybrid EEG/EOG-based brain/neural hand exoskeleton restores fully independent daily living activities after quadriplegia. Sci Robot, 2016; 1: eaag3296

- Hazubski S, Hoppe H, Otte A. Electrode-free visual prosthesis/exoskeleton control using augmented reality glasses in a first proof-of-technicalconcept study. Sci Rep, 2020; 10: 16279

- Hazubski S, Hoppe H, Otte A. Electrode-free visual prosthesis/exoskeleton control using augmented reality glasses in a first proof-of-technicalconcept study. Sci Rep, 2020; 10: 16279

- Strzeletz S, Hazubski S, Moctezuma JL, Hoppe H. Fast, robust, and accurate monocular peer-to-peer tracking for surgical navigation. International Journal of Computer Assisted Radiology and Surgery, 2020; 10.1007/s11548-019–02111‑z

- Video: Hand prosthetic controlled via augmented reality. Research Square, 2020 https://www.researchsquare.com/article/rs-107496/v1.

- Hazubski S, Hoppe H, Otte A. Electrode-free visual prosthesis/exoskeleton control using augmented reality glasses in a first proof-of-technicalconcept study. Sci Rep, 2020; 10: 16279